Windows Server Failover Cluster unter VMware

Aus znilwiki

Das wird hier eine Sammlung zu einem Windows File Failover Cluster unter VMware 7.0 - ist noch in Arbeit!

Anleitung von VMware: https://docs.vmware.com/en/VMware-vSphere/7.0/vsphere-esxi-vcenter-server-70-setup-wsfc.pdf

Vorbereitung

Datenspeicher

Wir brauchen einen "normalen" VMFS Datenspeicher, ganz normal wie immer. Auf diesem liegen die VMs der Cluster-Knoten.

Also die VM mit Ihren Konfigurationsdateien und Festplatte **C:**

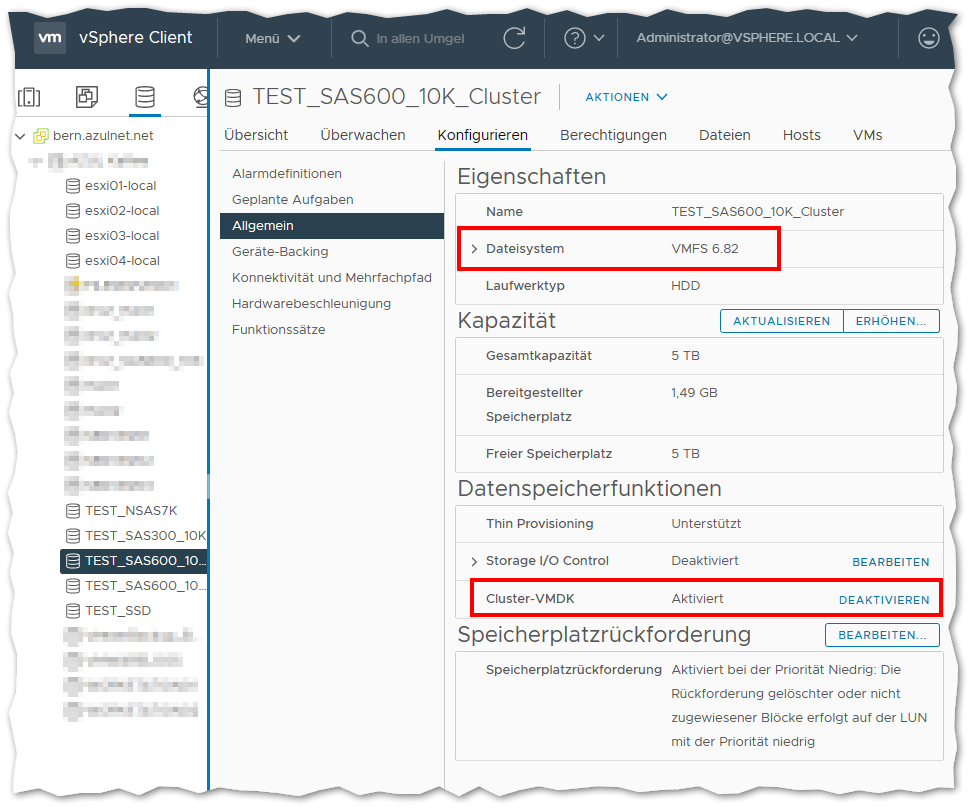

Für die Cluster-Festplatte, also die VMDK-Datei auf welche die einzelnen Windows-Cluster-Knoten einen gemeinsamen Zugriff haben sollen, benötigen wir einen VMFS-Datenspeicher mit aktivierter Cluster-VMDK Unterstützung:

Die Option dafür hat man unter folgenden Bedingungen:

- vCenter-Server 7.0.0 oder höher

- Alle ESXi-Server die auf den Datenspeicher zugreifen müssen ESXi 7.0.0 oder höher sein

- Der Datenspeicher wurde mit VMFS 6 formatiert und den Hosts hinzugefügt

- Im Anschluss wurde die Cluster-VMDK Option aktiviert. Geduld, dauert eine Weile bis das umspringt.

Auf diesen Datenspeicher werden nun nur die Shared-VMDKs eines Cluster abgelegt, in diesem Fall hier also von einem Server-Paar.

Hier werden NICHT die Konfigurationsdateien sowie die Dateien der ersten Festplatte (Laufwerk C:) der Cluster-VMs abgelegt!!!!

IP-Adressen + Name

Die beiden Clusterknoten benötigen jeweils eine IP-Adresse.

Zusätzlich wird eine weitere IP-Adresse für die gemeinsame Cluster-Adresse benötigt:

192.168.0.60 fileserver.test.local 192.168.0.61 file01.test.local 192.168.0.62 file02.test.local

Die beiden Knoten legen sich selbst im DNS an wenn die Server der Domäne hinzugefügt werden, den DNS-Eintrag für die Cluster-IP habe ich händisch im DNS angelegt.

Windows VMs

Ich habe hier 2x Windows Server 2019 Standard Version 1809.14 installiert. Die Einstellungen der VM habe wie folgt angepasst:

- Festplatte 1:

100 GB - SCSI-Controller 0:

LSI Logic SAS(entspricht der Vorgabe für Server 2019) - Netzwerkadapter:

VMXNET 3(Anforderung von VMware und 10G Netzwerkgeschwindigkeit) - Grafikkarte:

64 MB(Keine Probleme mit der Auflösung des Konsolenfensters)

Dann Windows installieren und durchpatchen. Ob es Standard oder Datacenter ist, ist egal.

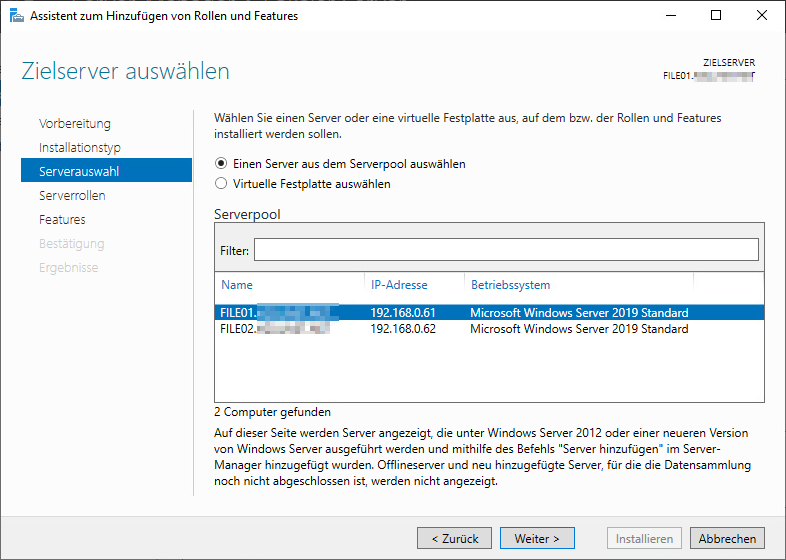

Für das Beispiel hier verwende ich 2 VMs, FILE01 und FILE02

Beide nehme ich in die vorhandene Domäne auf.

Automatische Windows-Updates habe ich per sconfig deaktiviert.

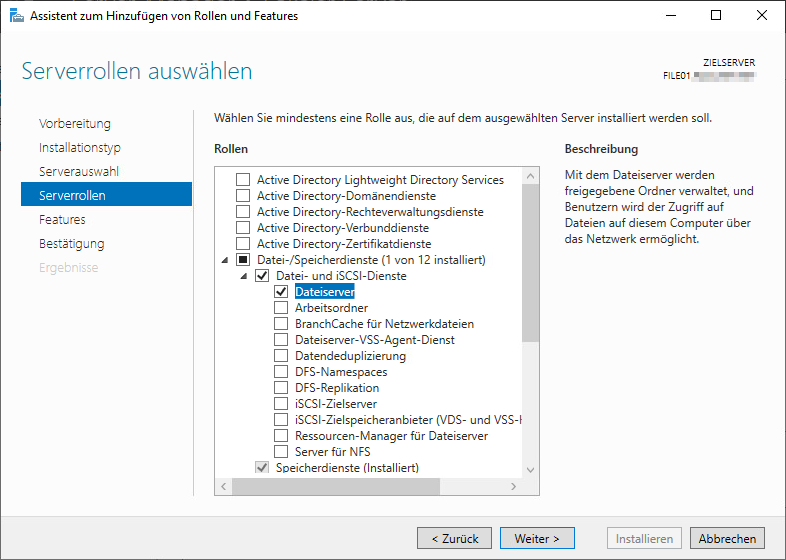

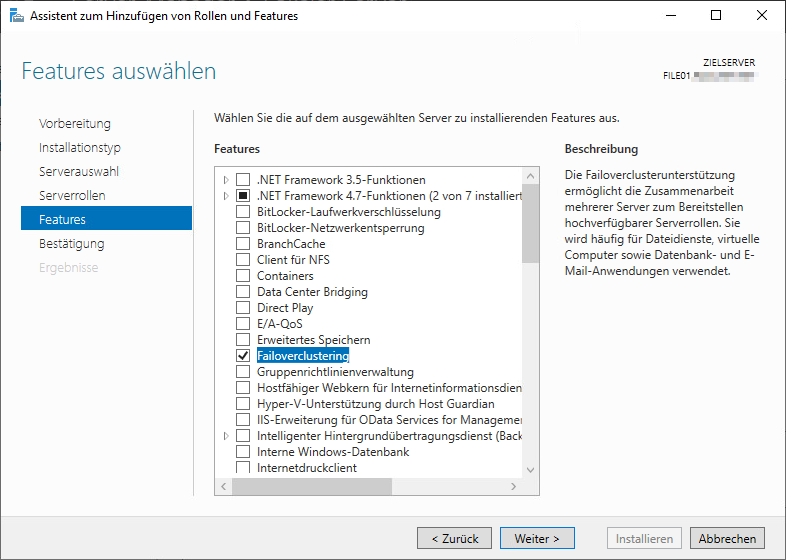

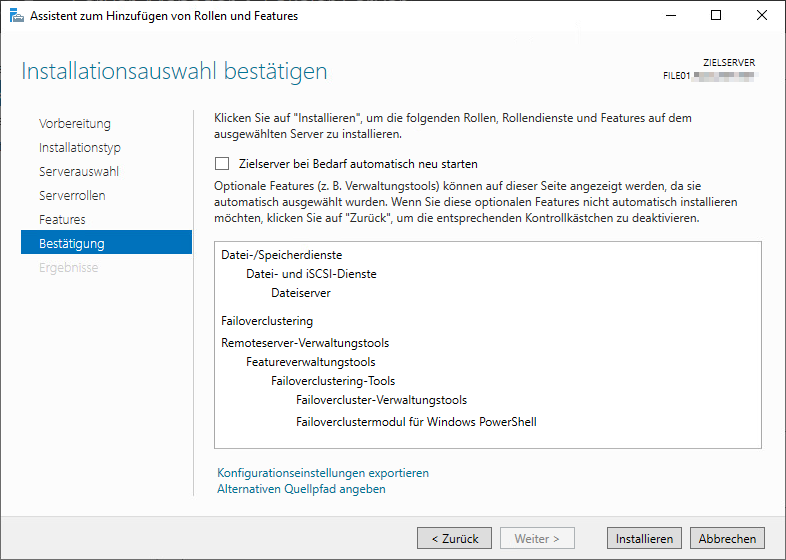

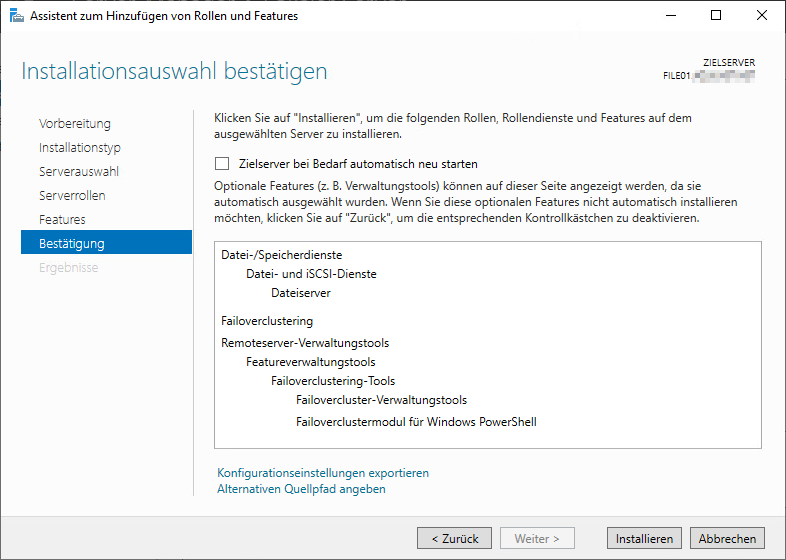

Rollen und Features Installieren

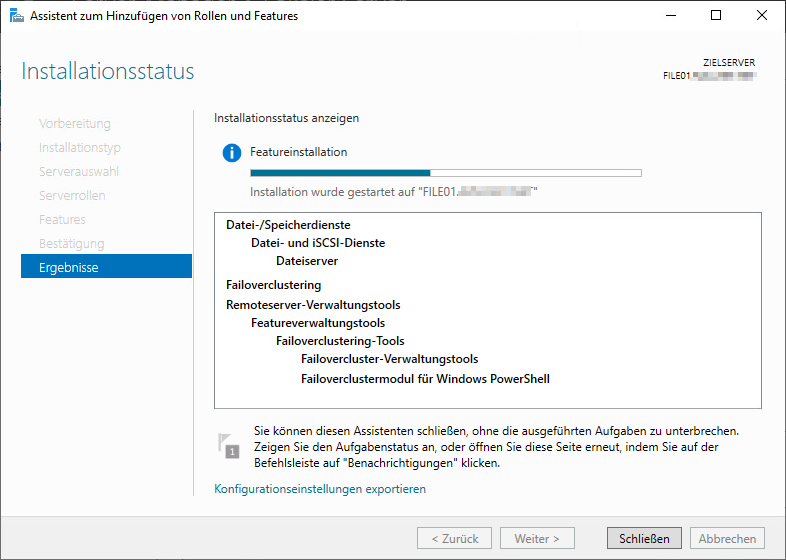

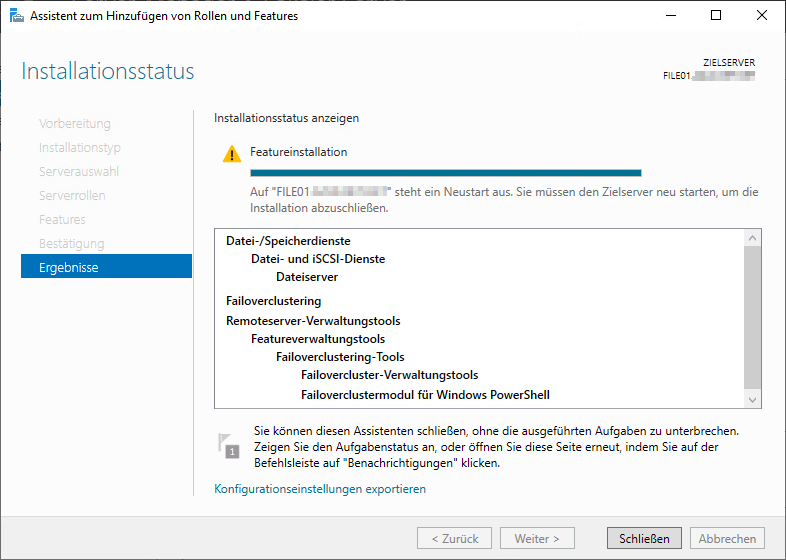

Auf beiden Windows-Server installieren wir folgendes nach:

Dann den Server neu starten.

Im Anschluss das Ganze auf dem 2. Server wiederholen.

Cluster VMDK hinzufügen

Man kann im Cluster mit oder ohne eine Quorum-Festplatte bzw. einem Whitness-Server arbeiten. Hier befinden sich beide Clusterknoten in einem VMware HA Cluster an einem Standort, deshalb verzichte ich darauf.

Erster Cluster-Knoten

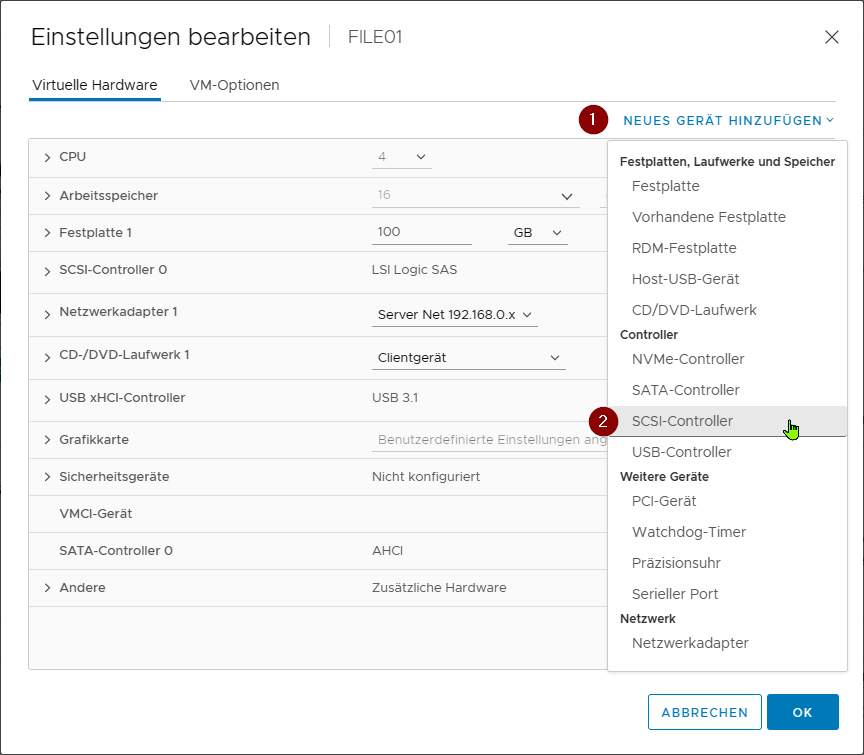

Wir bearbeiten die Hardware-Einstellungen der VM wie folgt:

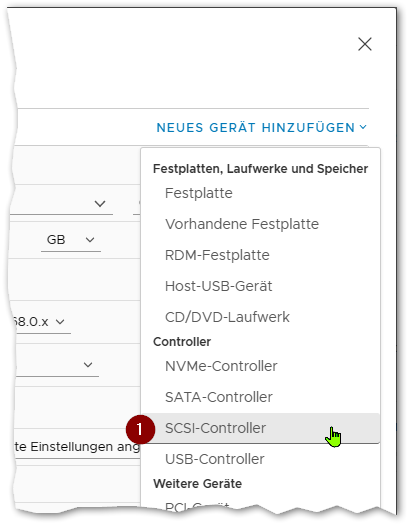

Zuerst fügen wir einen neuen SCSI-Controller hinzu:

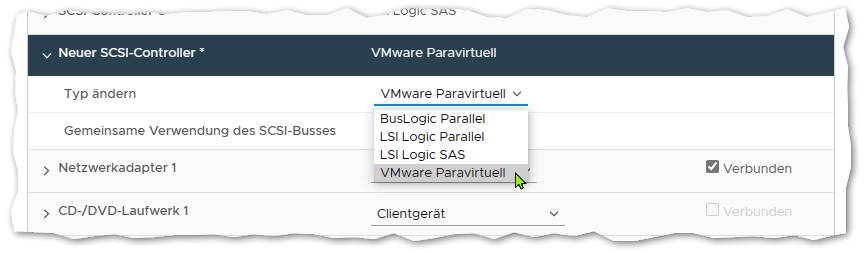

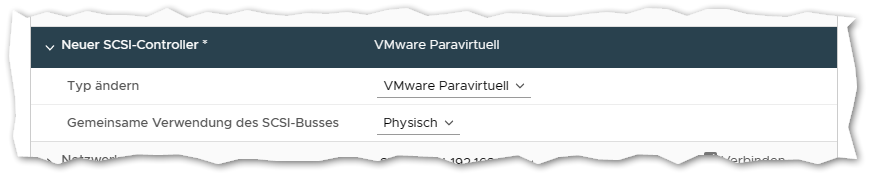

Diesen suchen wir danach in der Liste und ändern den Typ auf VMware Paravirtuell:

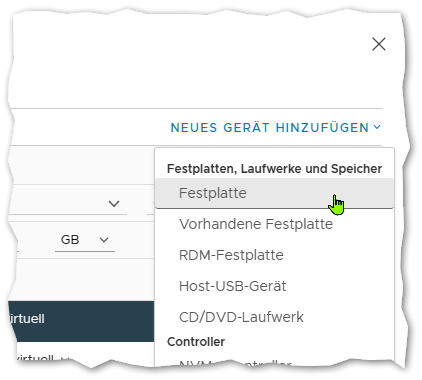

Dann fügen wir eine neue Festplatte hinzu:

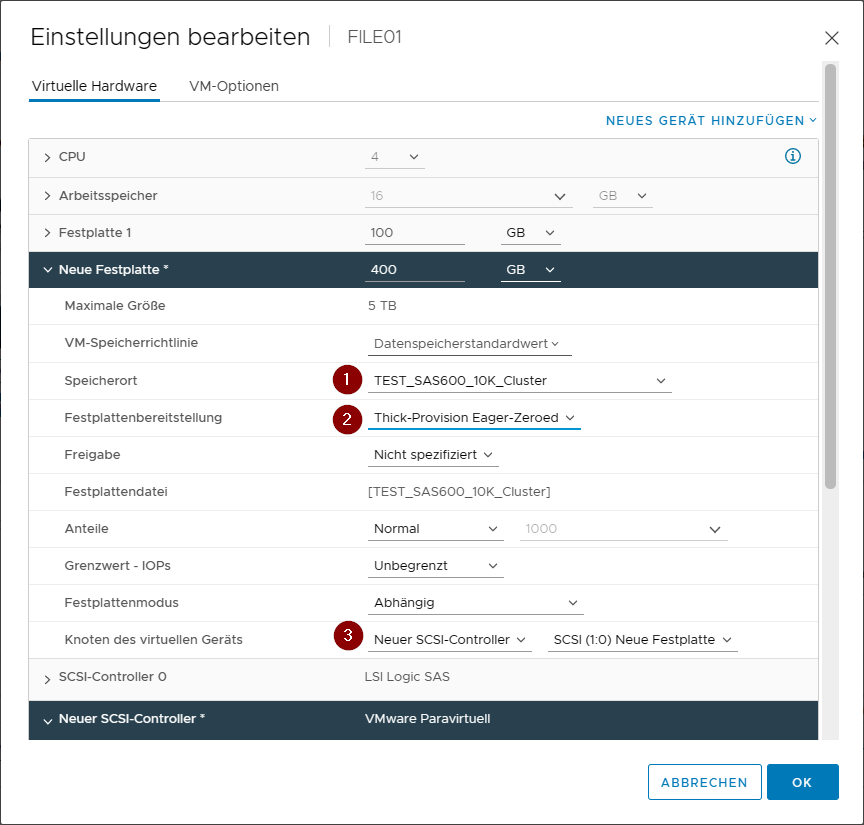

Als Speicherort wählen wir den VMFS Datenspeicher auf dem wir zuvor die Datenspeicherfunktion Cluster-VMDK aktiviert haben.

Bei Festplattenbereitstellung wählen wir als Typ Thick-Provision Eager-Zeroed. Bei der Erstellung wird er den Datenträger komplett ausnullen (also mit 0 vollschreiben).

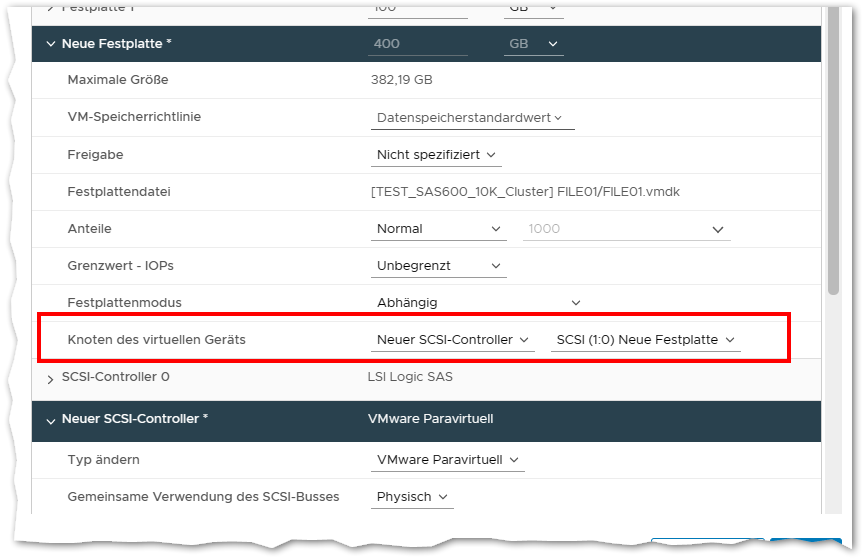

Bei Knoten des virtuellen Geräts wählen wir Neuer SCSI-Controller, die SCSI-ID sollte dann von allein auf SCSI (1:0) springen. Er wird hier nun den zuvor hinzugefügten neuen VMware Paravirtuell Controller verwenden.

Dann auf OK klicken - und warten. Er wird einen Moment brauchen die VMDK bereit zu stellen und mit 0en zu beschreiben.

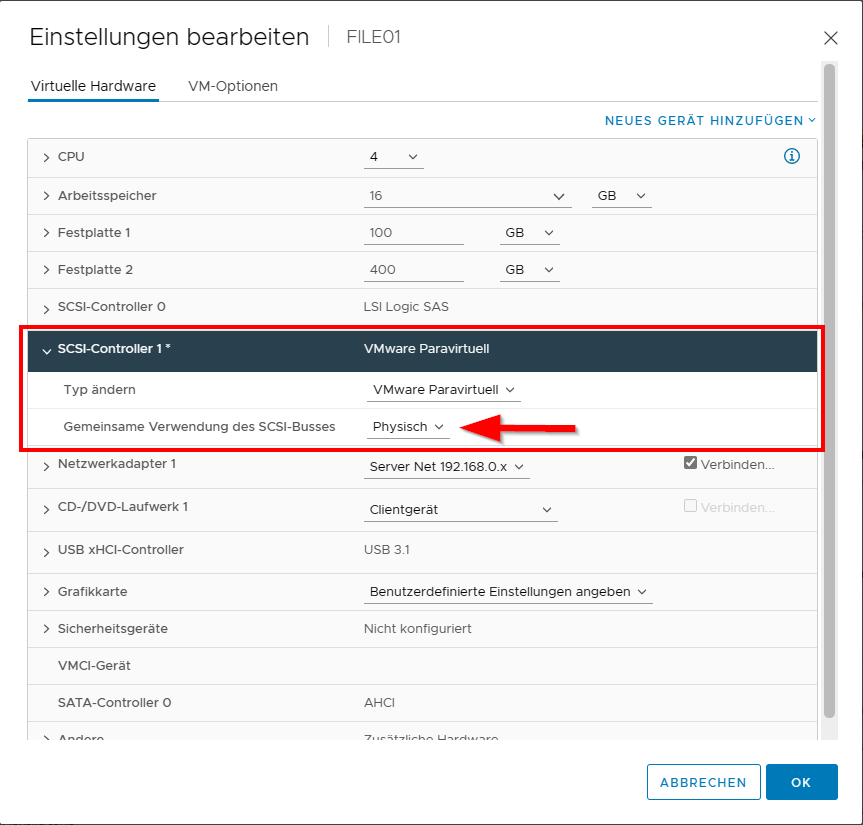

Wenn er fertig damit ist die VM nochmals bearbeiten:

Und für den SCSI-Coontroller 1 die Gemeinsame Verwendung des SCSI-Busses auf Physisch umstellen.

Die VM kann jetzt wieder eingeschaltet werden.

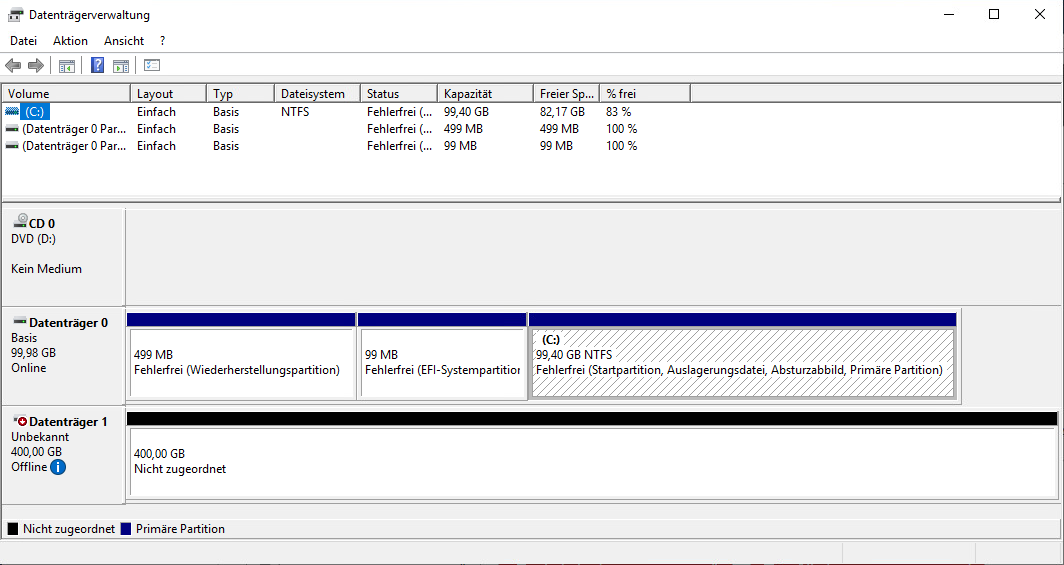

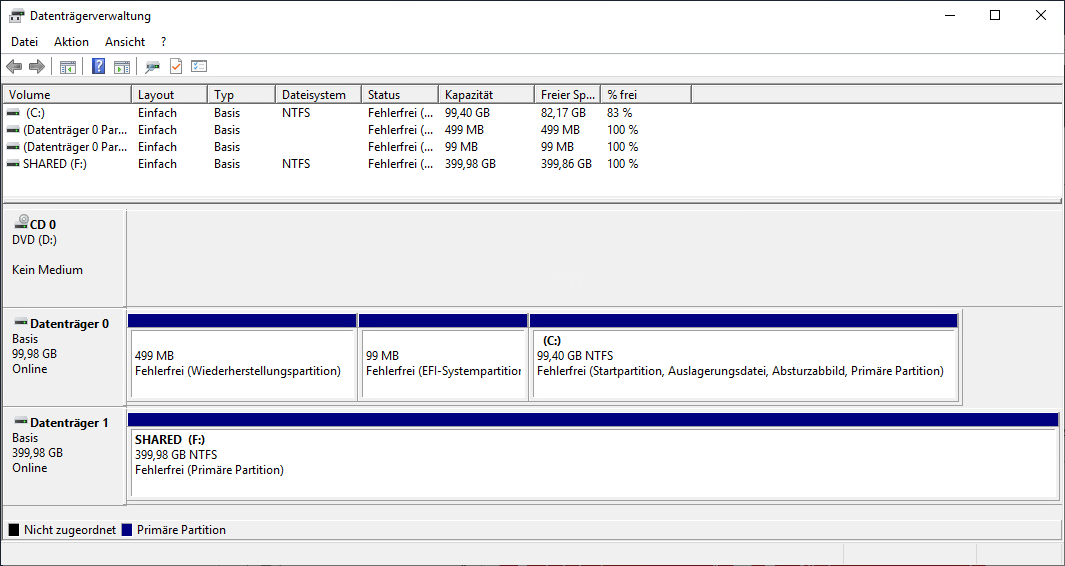

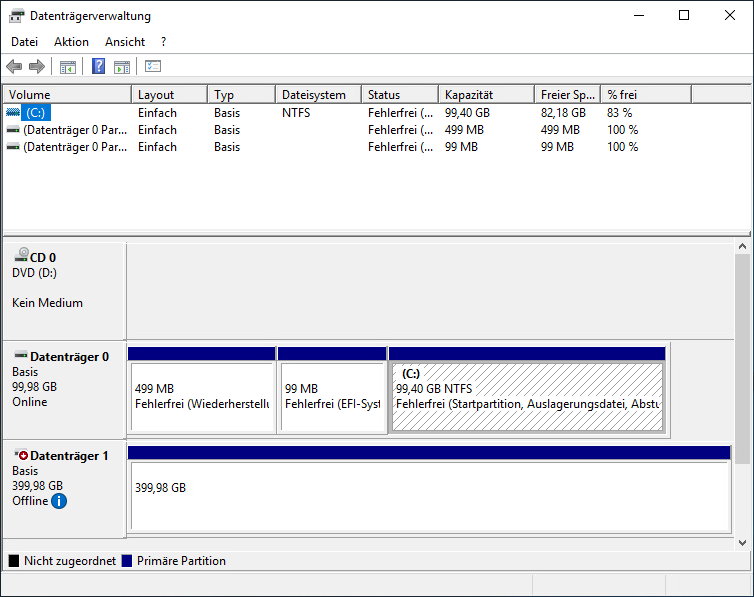

Wir melden uns an und rufen die Datenträgerverwaltung auf:

Den neuen Datenträger nehmen wir Online, Initialisieren den Datenträger mit GPT und erstellen eine neue NTFS Partition mit einem beliebigen Laufwerksbuchstaben:

Jetzt fügen wir die Festplatte am 2. Clusterknoten hinzu.

Erster Cluster-Knoten

Auch diese VM muss dazu ausgeschaltet sein - das gleichzeitige Hinzufügen des neuen SCSI-Controllers und der vorhandenen Festplatte funktioniert sonst nicht!

Wir bearbeiten die Hardware-Einstellungen der VM wie folgt:

Also SCSI-Controller hinzufügen und diesen auf VMware Paravirtuell und Physisch ändern.

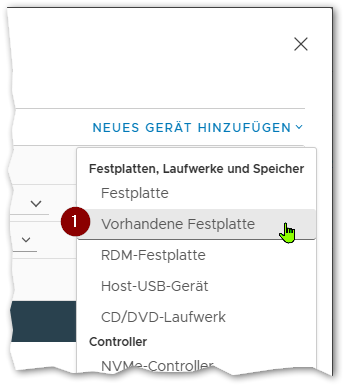

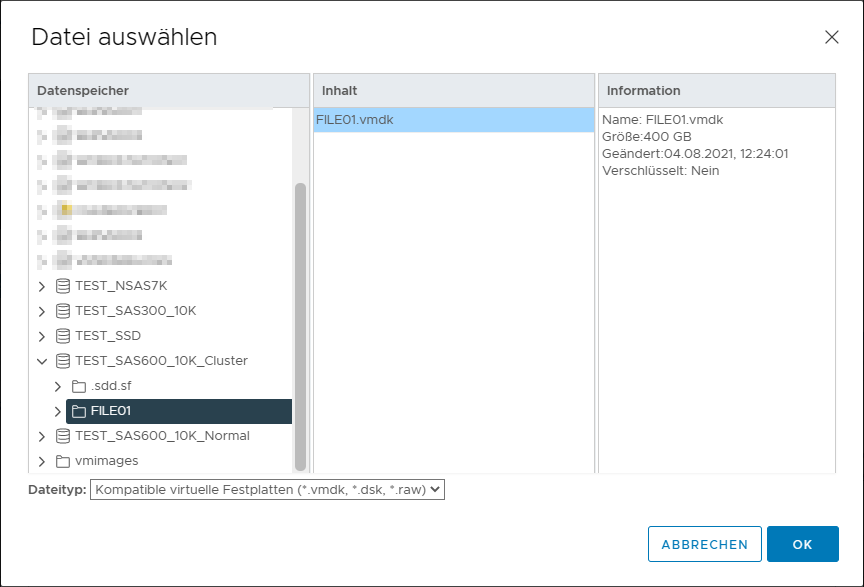

Dann fügen wir eine vorhandene Festplatte hinzu:

Im Dialog wählen wir die bereits vorhandene Festplatte des ersten Knotens auf dem Datenspeicher mit der aktivierten Cluster-VMDK Option.

Die Einstellung der neuen Festplatte müssen wir noch bearbeiten das auch diese den neuen Controller mit der gleichen SCSI-ID verwendet:

Dann auf OK klicken und die VM wieder starten.

In der VM überprüfen ob der Datenträger in der Datenträgerverwaltung zu sehen ist:

Zweiter Cluster-Knoten

Cluster Grundkonfiguration

Nach dem wir zuvor die notwendigen Rollen und Features nachinstalliert und beide Knoten neu gestartet haben, starten wir auf dem ersten der beiden Knoten den Failovercluster-Manager: