VMware:Trunking Etherchannel Link Aggregation mit ESX und ESXi

Aus znilwiki

Switche können untereinander mit mehr als einer Netzwerkverbindung verbunden werden,

man fasst z.B. 2 x 1 GBit Port zu einem Trunk zusammen so das die Switche nun mit 2 GBit verbunden sind.

Eine einzelne Verbindung kann zwar trotzdem nicht mehr als 1 GBit an Leistung herausholen, die Last wird aber über alle im Trunk vorhandenen Ports verteilt,

wenn also eine Leitung ausgelastet ist werden die Daten der anderen automatisch über die anderen Trunk-Ports geleitet.

Unter VMware ESX / ESXi können wir nun das Problem haben,

das wir einem VMNetwork z.B. 4 Netzwerkkarten zugeteilt haben ...

wenn wir uns aber den Datenverkehr anschauen sehen wir das er effektiv nur eine davon

tatsächlich benutzt.

In einem VMware View Pool hatten wir so ein Problem mit langen Antwortzeiten / Latenzen - obwohl die Bandbreite nicht einmal ansatzweise genutzt wurde.

Da ein ESX/ESXi Server auch einen Switch "simuliert" kann er natürlich auch mit den Trunks umgehen und so wird ein richtiger Switch die Last gleichmäßig verteilen.

Die Trunks haben viele Bezeichnungen, wenn ich hier im Text das Wort Trunk verwende steht es auch für:

- Etherchannel

- Link Aggregation

usw.

Einschränkungen

- . der Switch muss Trunking / Link Aggregation / Ether Channel beherrschen

- . Dafür muss ein eigener Virtueller Switch (

vswitch) erstellt werden - . alle Netzwerkarten an diesem

vswitchmüssen in einem einzigen Trunk / Ether-Channel/ Link-Aggregation sein! - . Und somit müssen die Netzkarten (

vmnic) auch alle an dem gleichen Switch hängen - . Service Consolen / Mangement Schnittstellen / VMKernel-Schnittstellen überschreiben die vSwitch Einstellungen! Diese müssen ebenfalls entsprechend angepasst werden

- . Das ganze Funktioniert erst seit vSphere 4.x richtig wie es soll - in Vor-Versionen lasst die Finger davon.

Am Switch

Ihr sucht euch die Ports aus am Switch und richtet diese als Trunk ein - mehr nicht.

Wie das am jeweiligen Switch geht ist je nach Modell verschieden - schaut also in der Anleitung dazu nach.

Am ESX/ESXi Server

Patcht die entsprechenden Netzwerkkarten-Schnittstellen auf den Switch.

Die NICs könne dabei bunt gemischt über alle möglichen Nezwerkkarten (interne, externe etc.) kommen.

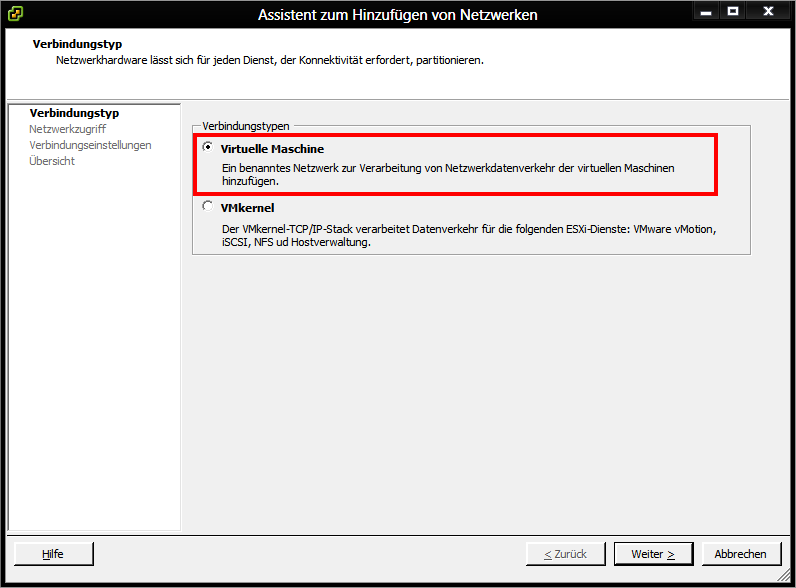

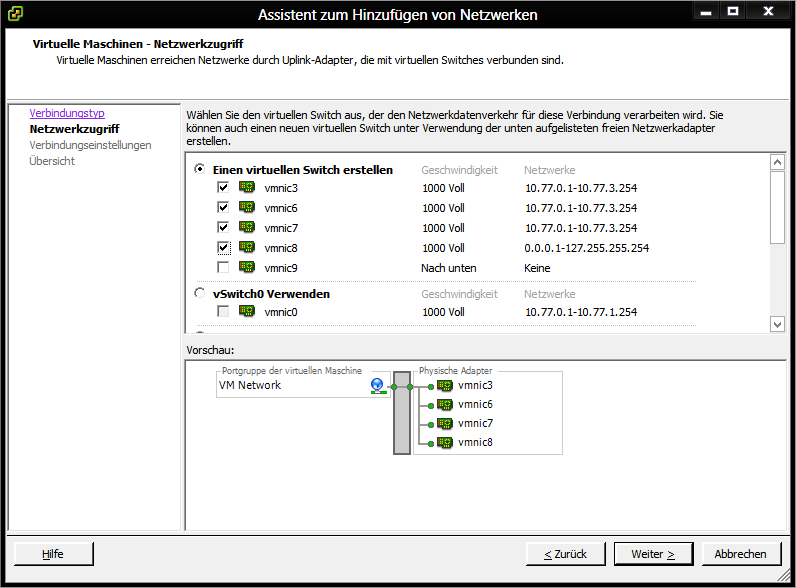

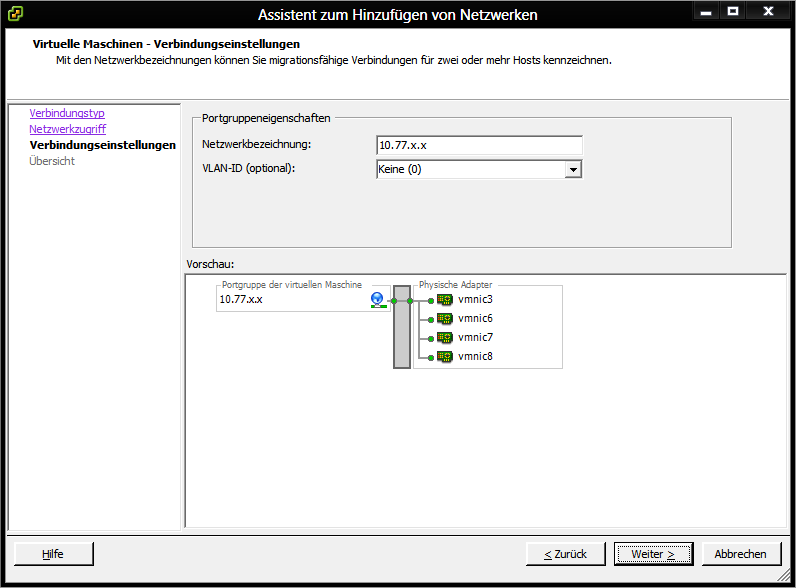

Erstellt am ESX/ESXi Server ein neues Netzwerk für virtuelle Maschinen und wählt die NICs dafür aus:

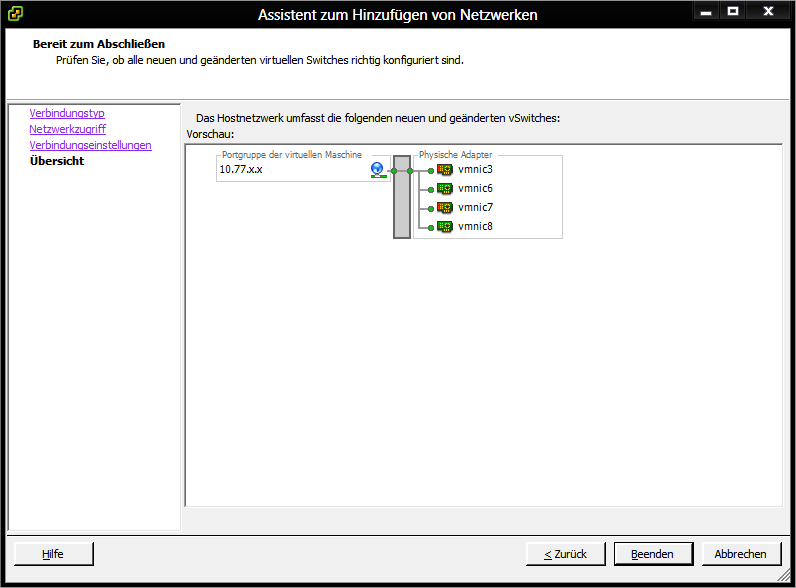

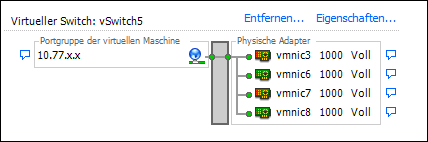

Wenn es fertig ist sieht es in etwa so aus:

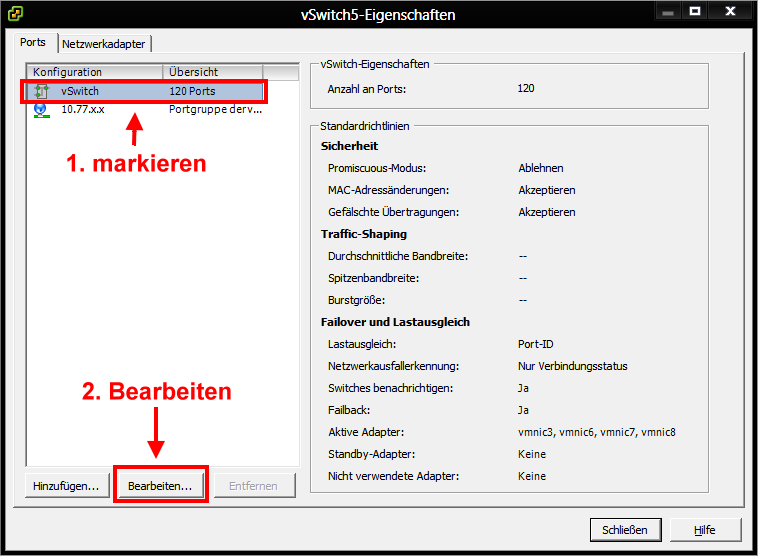

geht nun in die Eigenschaften und wählt den virtuellen Switch aus:

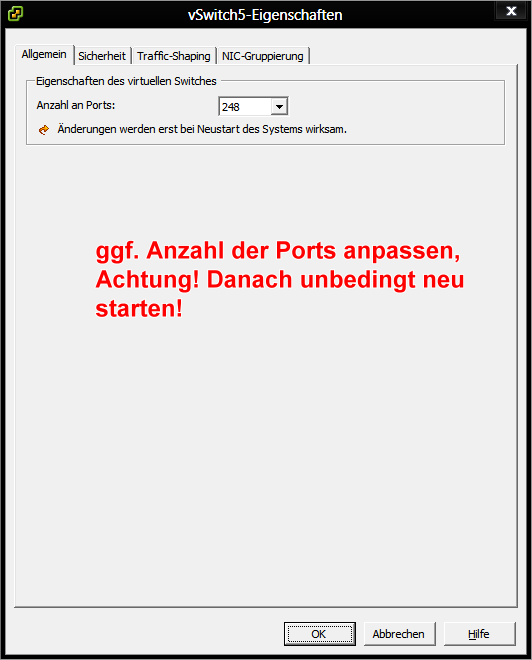

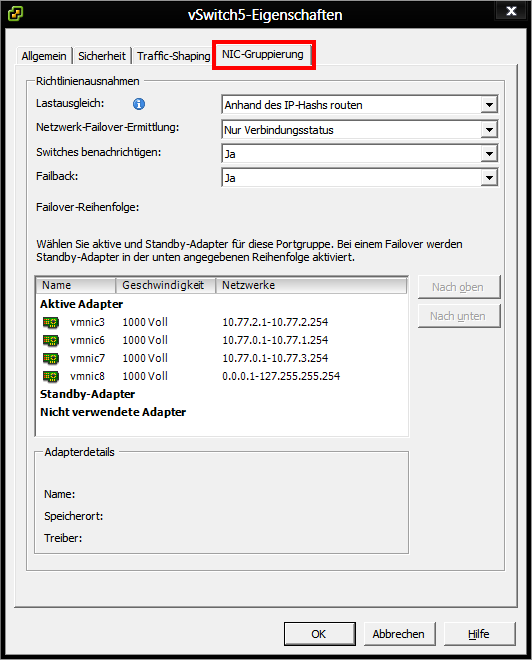

Und nun die Einstellungen für das Trunking:

Die Einstellungen müssen so und nicht anders sein in den ersten 3 Feldern.

Was bei Failback steht ist im Prinzip egal - wird in der Konfiguration eh nicht beachtet.

getestet mit

- 3COM Switchen

- Cisco Switchen

- HP Hewlett-Packard Switchen

Quellen: http://kb.vmware.com/selfservice/microsites/search.do?language=en_US&cmd=displayKC&externalId=1004048

und wie immer www.google.de

--Bernhard Linz 10:49, 29. Apr. 2013 (CEST)